- Obszary wykorzystania AI w sektorze finansowym

- Dlaczego wykorzystanie rozwiązań opartych na AI wymaga regulacji prawnych?

- Systemy i modele AI według AI Act

- Postanowienia AI Act

- Instytucje finansowe w obliczu rozwoju technologii AI

Sztuczna inteligencja (AI) odgrywa coraz bardziej istotną rolę w życiu ludzi i funkcjonowaniu organizacji, wpływając zarówno na codzienne czynności, jak i operacje biznesowe. Wykorzystanie systemów AI może przynosić korzyści – budzi jednak przy tym wiele obaw i prowokuje dyskusje na temat jego regulacji.

W obliczu tych wyzwań Parlament Europejski przyjął rozporządzenie unijne w sprawie sztucznej inteligencji znane jako AI Act, które stanowi pierwszy kompleksowy akt prawny mający na celu uregulowanie rozwoju i wykorzystania AI na różnych rynkach, w tym w sektorze bankowym, w którym informacje finansowe i dane osobowe muszą być odpowiedzialnie przetwarzane i skutecznie chronione.

Czym jest regulacja europejska dotycząca etycznego wykorzystania AI i jakie znaczenie ma dla bankowości? Tym kwestiom przyjrzymy się w poniższym artykule.

Obszary wykorzystania AI w sektorze finansowym

Wśród procesów bankowych wykorzystujących sztuczną inteligencję możemy wyróżnić następujące:

- Customer due diligence (CDD): weryfikacja tożsamości i profilu ryzyka na potrzeby oceny istotnych faktów dotyczących osoby fizycznej lub firmy w celu ograniczenia ryzyka związanego z przestępstwami finansowymi.

- Scoring kredytowy: ocena zdolności kredytowej na podstawie algorytmów AI.

- Wykrywanie oszustw finansowych: analiza transakcji w celu rozpoznawania niespójności, identyfikowania podejrzanych wzorców i wykrywania nieuczciwych operacji.

- Automatyzacja procesów: optymalizacja pracy poprzez automatyzację powtarzalnych czynności manualnych.

- Obsługa klienta z wykorzystaniem AI: automatyzacja procesów obsługi klienta z wykorzystaniem chatbotów, robo-doradców i wirtualnych asystentów.

- Personalizacja usług: personalizowana komunikacja i oferty dopasowanych usług oparte na określonych cechach klienta i wcześniejszych jego działaniach.

- Systemy zbierania opinii od klientów: systemy wykorzystywane do zbierania i przetwarzania opinii klientów w celu pomiaru ich zadowolenia, a następnie poprawy ich doświadczeń.

Procesy te wykorzystują modele przetwarzania języka w celu analizowania i systematyzowania dużych ilości danych w sposób szybszy i bardziej precyzyjny niż w przypadku przetwarzania ręcznego. W związku z tym wszystkie powyższe przykłady podlegają regulacji zgodnie z unijną ustawą o sztucznej inteligencji.

Dlaczego wykorzystanie rozwiązań opartych na AI wymaga regulacji prawnych?

Sztuczna inteligencja może być wykorzystywana do wielu celów, od zastosowań rozrywkowych po wysoce wyspecjalizowane aplikacje biznesowe. Jako że ma ona potencjał naśladowania, symulowania i rozszerzania rzeczywistości, z jej nieetycznym wykorzystaniem wiąże się szereg zagrożeń: od wprowadzających w błąd treści generowanych przez AI (deepfake’ów) poprzez stronniczość algorytmów aż po naruszenia prywatności. Aby im zapobiec, należy ustanowić jasne wytyczne dotyczące odpowiedzialnej dystrybucji i wykorzystania AI.

Systemy i modele AI według AI Act

Unijna ustawa o sztucznej inteligencji objaśnia system AI jako system maszynowy zaprojektowany w celu działania na różnym poziomie autonomii. Cechami charakteryzującymi takie narzędzie są również zdolność do adaptacji po wdrożeniu oraz możliwość wnioskowania, jak generować wyniki w oparciu o dane wejściowe. Te wyniki mogą przybrać formę predykcji, treści, zaleceń lub decyzji wpływających na środowisko fizyczne lub wirtualne.

Ustawa nie definiuje jednak modelu AI. W jej treści znaleźć można jedynie wzmiankę o “modelach AI ogólnego przeznaczenia”, które są szkolone na dużych zbiorach danych i potrafią wykonywać szeroki zakres różnych zadań.

Kryteria definicji systemu AI

W ustawie zaznaczono, że ustalenie, czy dane oprogramowanie jest systemem AI powinno opierać się na ocenie jego architektury i funkcjonalności przy uwzględnieniu siedmiu elementów definicji:

- Warunek konieczny: system maszynowy. System AI musi być zbudowany oraz działać na maszynach zarówno w sensie sprzętowym, jak i w rozumieniu oprogramowania.

- Warunek konieczny: system zaprojektowany z różnym poziomem autonomii. Autonomię definiuje się tutaj w kontekście interakcji człowieka z maszyną, a system AI w tym wypadku rozumie się jako system, który może działać bez względu na to, czy w jego funkcjonowanie zaangażowany jest człowiek. Manualne dostarczanie danych wejściowych w celu wygenerowania wyniku przez system nie odbiera mu autonomii – a zatem opisywanego warunku nie spełniają jedynie narzędzia wymagające pełnego zaangażowania człowieka w ich działanie.

- Warunek fakultatywny: system może wykazywać zdolności adaptacyjne. System może mieć zdolność samouczenia również na etapie użytkowania już po wdrożeniu. W efekcie w oparciu o te same dane wejściowe może on generować różne wyniki.

- Warunek konieczny: cel działania systemu jest zdefiniowany lub dorozumiany. Cele dorozumiane to cele, które nie zostały jasno określone przez twórcę, jednak mogą wynikać z czynników takich, jak interakcja systemu z otoczeniem. Ten warunek jest w praktyce zawsze spełniony.

- Warunek konieczny: system generuje dane wyjściowe. System ma zdolność wnioskowania, w jaki sposób generować wyniki poprzez możliwość tworzenia modeli lub algorytmów AI w oparciu o dane wejściowe. Spełnienie tego warunku umożliwiają określone techniki modelowania.

- Warunek konieczny: typy generowanych rezultatów. Narzędzia AI wykorzystują zaawansowane systemy modelowania i złożone wzorce w celu generowania wyników, które kategoryzuje się odpowiednio jako prognozy, treści, zalecenia lub decyzje. Ten warunek jest w praktyce zawsze spełniony.

- Warunek fakultatywny: wyniki mogą wpływać na środowisko fizyczne lub wirtualne. Oznacza to, że wyniki generowane przez systemy AI znajdują zastosowanie w rzeczywistych procesach. Ten aspekt ma szczególnie istotne znaczenie w procesie oceny ryzyka związanego z wykorzystaniem sztucznej inteligencji. Ten warunek jest w praktyce zawsze spełniony.

Wystąpienie powyższych warunków może mieć miejsce wybiórczo na etapie budowania lub użytkowania systemu.

Klasyfikacja metod modelowania

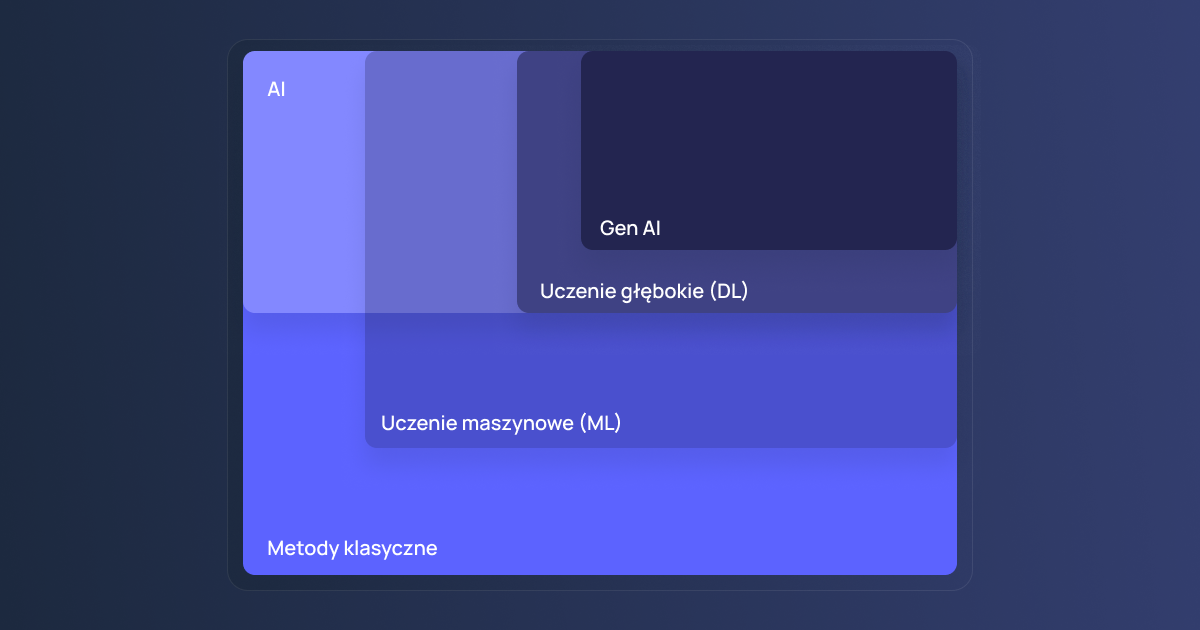

Metody modelowania to techniki matematyczne i algorytmiczne służące do reprezentowania rzeczywistych procesów w postaci modeli, które pozwalają na ich analizę, prognozowanie lub optymalizację. W zależności od podejścia mogą opierać się na regułach i wzorach lub na danych i samouczeniu się.

Poniższa uproszczona klasyfikacja oparta jest na dokumencie podsumowującym prace grupy roboczej ds. AI Forum Technologii Bankowych z kwietnia 2025.

Modelowanie klasyczne przebiega w oparciu o stałe reguły i formuły tworzone przez człowieka, podczas gdy sztuczna inteligencja oparta jest na algorytmach z elementem uczenia się służących do tworzenia systemów zdolnych do wykonywania zadań, które zazwyczaj wymagają ludzkiej inteligencji.

Metody uczenia maszynowego (ML) częściowo wpisują się w obie powyższe kategorie, jednak nie zawsze ich klasyfikacja będzie jednoznaczna. Podczas gdy tradycyjne modele ML, takie jak regresja liniowa lub drzewa decyzyjne, opierają się na ustalonych regułach matematycznych i określonej logice, istnieją bardziej zaawansowane metody uczące się wzorców na podstawie informacji zwrotnych.

Metody uczenia głębokiego (DL) stanowią podzbiór uczenia maszynowego. Wykorzystują wielowarstwowe sieci neuronowe w celu analizy złożonych wzorców i dużych zbiorów danych. Znajdują zastosowanie w procesach analizy dźwięków, rozpoznawania obrazów czy przetwarzania języka naturalnego (NLP).

Generatywna sztuczna inteligencja (GenAI) to podzbiór uczenia głębokiego obejmujący metody uczące się na wzorach czerpanych z dużych zbiorów danych w celu generowania podobnych treści, takich jak obrazy, filmy czy dźwięki.

Każda z powyższych metod modelowania ma różne możliwości, zastosowanie i ograniczenia. Odpowiednia klasyfikacja systemów AI pozwala na wykorzystywanie ich w sposób efektywny i odpowiedzialny, umożliwiający ograniczenie potencjalnego ryzyka dla bezpieczeństwa.

Postanowienia AI Act

Ustawa o sztucznej inteligencji ma na celu ustanowienie zasad bezpiecznego korzystania z AI przy zachowaniu podstawowych praw człowieka. Jednocześnie jej celem jest stymulowanie innowacji i zachęcanie do inwestowania w technologie wykorzystujące AI. Tym samym ustawa nie ma na celu zakazania lub ograniczenia korzystania ze sztucznej inteligencji – stanowi za to zachętę do odpowiedzialnego jej stosowania.

Rozporządzenie definiuje różne strony zaangażowane w wykorzystanie AI, od dostawców, przez podmioty wdrażające, importerów i dystrybutorów, po producentów. Jego przepisy mają zastosowanie do wszystkich podmiotów, które spełniają co najmniej jeden z poniższych wymogów:

- podmioty mające siedzibę lub zlokalizowane w UE, które wykorzystują systemy sztucznej inteligencji do celów biznesowych,

- podmioty mające siedzibę lub zlokalizowane w UE lub poza nią, dostarczające narzędzia sztucznej inteligencji na rynek UE,

- podmioty mające siedzibę lub zlokalizowane w UE lub poza nią, które wykorzystują systemy sztucznej inteligencji do celów biznesowych, w przypadku gdy wyniki pracy tych narzędzi są wykorzystywane w Unii Europejskiej.

Należy zaznaczyć, że unijna ustawa o sztucznej inteligencji ma zakres „horyzontalny”. Oznacza to, że zamiast odnosić się do poszczególnych branż, takich jak sektor finansowy lub określone rodzaje systemów sztucznej inteligencji, rozporządzenie ma szerokie zastosowanie i koncentruje się na wykorzystaniu sztucznej inteligencji w różnych obszarach i na różnych terytoriach. Pod tym względem ustawa przypomina przepisy RODO i DORA, które również mają charakter ogólny.

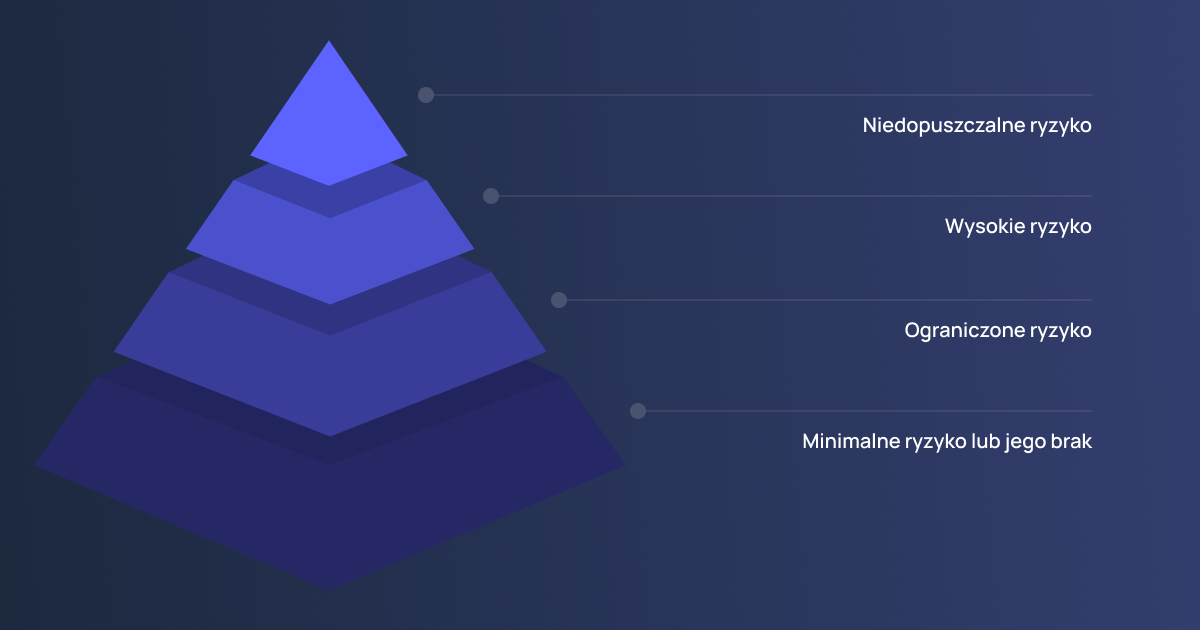

Wielopoziomowa klasyfikacja ryzyka związanego z wykorzystaniem sztucznej inteligencji

Na potrzeby uregulowania wykorzystania technologii AI, prawodawca europejski usystematyzował zasady stosowania różnych przepisów w oparciu o poziomy ryzyka związanego z danym narzędziem lub jego zastosowaniem.

- Niedopuszczalne ryzyko. Kategoria ta obejmuje systemy oparte na scoringu społecznościowym, a także systemy wykorzystujące zdalną identyfikację biometryczną w czasie rzeczywistym. Korzystanie z nich jest surowo zabronione na mocy ustawy o sztucznej inteligencji.

- Wysokie ryzyko. Przed wejściem na rynek systemy wysokiego ryzyka muszą przejść ocenę zgodności, a ich użycie jest dozwolone, jeśli podmiot operacyjny zapewni odpowiednie procesy zarządzania ryzykiem, procedury ochrony danych i środki cyberbezpieczeństwa. W sektorze finansowym narzędzia należące do tej kategorii obejmują modele scoringu kredytowego i systemy wykrywania oszustw.

- Ograniczone ryzyko. Rozwiązania poprawiające doświadczenie klienta, takie jak chatboty czy wirtualni asystenci, a także generatywne systemy AI, podlegają wymogom dotyczącym przejrzystości. Oznacza to, że użytkownik musi zostać poinformowany, że treści, które przegląda lub z którymi wchodzi w interakcję są generowane przez sztuczną inteligencję.

- Minimalne ryzyko lub jego brak. Chociaż dla tej kategorii nie określono żadnych obowiązkowych wymogów, ustawa o sztucznej inteligencji zachęca wszystkie strony zaangażowane w produkcję, dystrybucję i wdrażanie systemów AI o minimalnym ryzyku do przestrzegania odpowiednich kodeksów postępowania.

Tym samym unijna ustawa o sztucznej inteligencji obejmuje szereg różnych systemów i rozwiązań wykorzystywanych w wielu branżach, zapewniając kompleksowe wytyczne dotyczące ich bezpiecznego i odpowiedzialnego użytkowania.

Kryteria klasyfikacji praktyk zakazanych przez AI Act w kontekście podmiotów finansowych

W toku klasyfikacji systemów opartych na AI pod kątem wiążącego się z ich wykorzystaniem ryzyka należy dokładnie przyjrzeć się kontekstowi, w jakim dane rozwiązanie ma być zastosowane. W tym miejscu konieczne będzie przeanalizowanie, jaki wpływ narzędzie może mieć na osoby fizyczne i ich prawa, z uwzględnieniem ryzyka potencjalnych szkód.

Praktyki zakazane na mocy przepisów rozporządzenia AI Act uwzględniają profilowanie osób fizycznych w celu przewidzenia lub oceny ryzyka popełnienia przez nie przestępstwa, kategoryzację osób fizycznych w oparciu o ich dane biometryczne w zakresie cech wrażliwych, a także wyciąganie wniosków na temat emocji osoby fizycznej na podstawie danych biometrycznych.

Wśród praktyk zakazanych znalazło się zastosowanie manipulacji lub technik podprogowych w celu wykorzystania słabości osób lub grup osób w związku z ich wiekiem, niepełnosprawnością albo trudną sytuacją społeczną lub ekonomiczną. Takim działaniem systemu AI w bankowości mogłoby być zastosowanie systemu personalizacji ofert finansowych wykorzystującego zniekształcone dane – dla przykładu, system opierający procesy o informacje dotyczące grup wiekowych klientów mógłby oferować produkty finansowe na niekorzystnych warunkach osobom starszym, skutkując wystąpieniem u nich szkód finansowych. Istotne jest więc zapewnienie, że dane i narzędzia stosowane przez banki w procesach wspieranych przez sztuczną inteligencję są wykorzystywane w sposób odpowiedzialny i adekwatny do zamierzonych celów.

Wśród mechanizmów zakazanych przez AI Act mających mniej prawdopodobny potencjał wykorzystania w bankowości możemy wyróżnić ponadto scoring społeczny oraz nieukierunkowane pozyskiwanie obrazów twarzy.

Kryteria klasyfikacji systemów wysokiego ryzyka w kontekście podmiotów finansowych

Zdecydowana większość obowiązków płynących z przepisów AI Act dotyczy systemów wysokiego ryzyka, w którą to kategorię wpisuje się również większość zastosowań sztucznej inteligencji w bankowości.

Wśród kryteriów klasyfikacji systemów AI jako rozwiązań wysokiego ryzyka znalazło się wykorzystanie systemów zdalnej identyfikacji biometrycznej, w tym narzędzi AI mających zastosowanie w celu kategoryzacji biometrycznej według cech wrażliwych. W obszarze zatrudnienia i zarządzania pracownikami banku, w tę kategorię wpisywać się będą również systemy używane w procesach rekrutacyjnych czy w toku przydzielania zadań pracownikom banku. Kolejne zastosowanie systemów AI w tej kategorii dotyczy zapewnienia bezpieczeństwa zarządzania krytyczną infrastrukturą cyfrową.

W zakresie obsługi klientów banku, pośród systemów wysokiego ryzyka znajdziemy narzędzia używane do oceny zdolności kredytowej i – rzadziej – narzędzia wykorzystywane do oceny ryzyka ubezpieczeniowego. Przykładem może być system dynamicznego monitorowania ryzyka kredytowego dla osób fizycznych, który w toku samoadaptacji w oparciu o nowe dane aktualizuje parametry oceny i podejmuje decyzje w oparciu o uzyskane wyniki.

Ustanowienie Europejskiego Urzędu ds. Sztucznej Inteligencji (European Artificial Intelligence Office)

Ustawa o sztucznej inteligencji przewidziała również utworzenie Europejskiego Urzędu ds. Sztucznej Inteligencji (European AI Office), organizacji nadzorującej przyjęcie przepisów AI Act, w skład której wchodzą przedstawiciele państw członkowskich UE. Urząd ma za zadanie wspierać rozwój i odpowiedzialne wykorzystanie technologii AI przy jednoczesnym zapewnianiu ochrony przed związanymi z nią zagrożeniami. Do jego obowiązków należy egzekwowanie zasad postępowania dotyczących modeli AI ogólnego przeznaczenia. Instytucja pełni również funkcję doradczą, wspierając organy zarządzające państw członkowskich w realizacji zadań wynikających z AI Act.

W pewnym zakresie nadzór i egzekwowanie przepisów ustawy o sztucznej inteligencji mają zostać powierzone organom odpowiedzialnym za konkretną branżę. W przypadku bankowości i usług finansowych będą to odpowiednie organy ds. usług finansowych w państwach członkowskich wraz z Europejskimi Urzędami Nadzoru (ESA): Europejskim Urzędem Nadzoru Bankowego (EBA), Europejskim Urzędem Nadzoru Giełd i Papierów Wartościowych (ESMA) oraz Europejskim Urzędem Nadzoru Ubezpieczeń i Pracowniczych Programów Emerytalnych (EIOPA).

Kluczowe daty dla AI Act

Biorąc pod uwagę jej preskrypcyjny charakter, natychmiastowe wdrożenie środków zapewniających przestrzeganie ustawy o sztucznej inteligencji byłoby zasadniczo niemożliwe dla większości organizacji. Z tego powodu proces wdrażania rozłożono na okres trzech lat.

- Ustawa o AI weszła w życie 1 sierpnia 2024, dając organizacjom czas na dostosowanie się do jej przepisów.

- Przepisy ogólne i zakaz stosowania systemów sztucznej inteligencji o niedopuszczalnym ryzyku zaczęły obowiązywać 2 lutego 2025. Jest to moment, w którym banki powinny już ustalić metody kwalifikacji systemów AI i zapobiegać stosowaniu zakazanych przez ustawę praktyk.

- W przypadku systemów sztucznej inteligencji ogólnego przeznaczenia wdrożenie kodeksów postępowania powinno było zostać zakończone do 2 maja 2025.

- Państwa członkowskie UE są zobowiązane do wyznaczenia własnych organów odpowiedzialnych za nadzorowanie zgodności z ustawą o sztucznej inteligencji do 2 sierpnia 2025. Zastosowanie mają od tego czasu również przepisy o karach administracyjnych.

- 2 sierpnia 2026 będzie ważną datą dla sektora bankowego, ponieważ wtedy wejdą w życie przepisy związane ze stosowaniem systemów AI wysokiego ryzyka, a większość technologii AI wykorzystywanych w usługach finansowych należy do tej kategorii. Spełniane muszą być również wymogi przepisów o obowiązkach informacyjnych związanych z AI.

Instytucje finansowe w obliczu rozwoju technologii AI

Z efektywnym wykorzystaniem sztucznej inteligencji w bankowości wiąże się wiele szans i możliwości optymalizacji procesów. Nieodpowiedzialne i nieumiejętne zastosowanie technologii AI może jednak nieść ze sobą poważne konsekwencje. Dlatego tak ważne jest, aby instytucje finansowe potrafiły zidentyfikować ryzyko związane z wdrażaniem nowoczesnych rozwiązań opartych na sztucznej inteligencji i odpowiednio mu przeciwdziałać.

Umiejętna interpretacja przepisów i zastosowań dla AI Act w bankowości to podstawowy krok w kierunku zapewnienia zgodności z regulacjami, zwiększania bezpieczeństwa i transparentności systemów AI, minimalizowania ryzyka prawnego oraz budowania zaufania klientów do technologii wykorzystywanych w usługach finansowych.